exportedFrom: 0891e98853b6745691d70c3ef5bb2fc2eccbf8e0 title: Manual de Periodismo de Datos lang: es pandocOptions: | [ ' --pdf-engine=lualatex -H preamble.tex --variable fontsize=12pt --variable documentclass:book --variable papersize:letter --variable classoption:openright --top-level-division=chapter ' ]

begin{titlepage} begin{center}

\vspace*{1cm}

% Dissertation No.

\vspace*{1cm}

\large{ \textbf{ \uppercase

{Manual de Periodismo de Datos}}}

\vspace{0.5cm}

\vspace{1.5cm}

\large{Versión: 1.0}\\

Revisión: 0891e98853

\vspace{0.8cm}

Editado por\\

\textbf{Jonathan Gray, \\ Liliana Bonegru \\ y Lucy Chambers}

\vspace{0.8cm}

% textit{PhD(c) en Diseño y Creación \ MSc en Educación \ Informático-Matemático}

\vspace{0.8cm}

\vspace{0.5cm}

\vspace{2cm}

%Insert Creative Commons Artwork DeclareGraphicsExtensions{.pdf,.png,.jpg} begin{center} leavevmode %Replace image file name below ("by-sa.png") with your license includegraphics[width=1in]{./img/cc-by-sa.png} end{center} label{fig:cc} %insert a link to the licence and its description below scriptsize{ Esta obra está licenciada bajo una licencia \ href{http://creativecommons.org/licenses/by-sa/3.0/}{Creative Commons Attribution-ShareAlike 3.0 Unported License} \ y puede ser copiada y modificada de acuerdo a los términos de dicha licencia.\ Una versión en línea actualizada de esta obra y su código fuente está publicada en: \ href{http://http://mutabit.com/repos.fossil/mapeda/}{http://mutabit.com/repos.fossil/mapeda/}}

\vfill

% copyright 2015 por Autores Colectivos

\end{center}

\thispagestyle{empty}

end{titlepage}

newpage thispagestyle{empty} mbox{}

tableofcontents

Prólogo a esta edición {-}

Muéstrame el código!

Existen interesantes obras culturales libres, que lo son de manera nominal, en la teoría, pero que no lo son en la práctica. Esto quiere decir que, a pesar de tener una licencia bastante liberal, que permite su remezcla, modificación e incluso venta, las infraestructuras que soportan la creación y publicación de dichas obras, no permiten amplia participación, ni tampoco la trazabilidad de la historia respecto a dichos procesos participativos y colaborativos. Dicho de una manera más técnica: su código fuente no está abierto, las herramientas con las que se hicieron no son de software libre y no cuentan con repositorios públicos para gestionar dicho código.

Esta no es una paradoja mejor: al licenciar las obras de manera que se aliente su tránsito y modificación, se está haciendo una invitación abierta. Pero al dejar invisibles las infraestructuras que efectivamente permiten a otros participar, se dificulta a todos aceptar dicha invitación. Esto pasa de manera generalizada con muchas fundaciones y colectivos que abren sus obras, pero no nos muestran el código fuente de las mismas, ni los lugares y formas donde apropiarnos del mismo y aportar a ellas. Es como si dijéramos que hemos organizado una fiesta en la playa y que todo el mundo puede ir, que habrá una dotación inicial de la música, bebidas y alimentos, y que estamos esperando hacer algo mucho mejor con los aportes de los demás. La fiesta será una creación colectiva potente. El único problema es que olvidamos decirle a la gente cómo llegar y es más, no pensamos en los que irían en bicicleta o a pie, sólo se puede llegar en vehículo motorizado. A la generosidad inicial, que sin duda agradecemos, la afecta la invisible infraestructura. Así que, aprovechando las libertades que ofrece la obra, hemos tomado una postura proactiva y abierto la creación a muchas más personas, ocupándonos de la infraestructura.

La nuestra es propuesta sobre una manera alternativa de crear colectivamente dichas obras libres, abordando el problema de la partipación y para ello hemos usando, como ejemplo, el Manual de Periodismo de Datos acá presente. Considerar a los de bicicleta y los de a pie, con hardware modesto y conectividad intermitente, como ocurre en el llamado Sur Global y la amplia latinoamérica, ha implicado optar por lo que yo llamo infraestructuras de bolsillo, que se caracterizan por ser sencillas, auto-contenidas, y funcionar bien en o fuera de línea, tales como Grafoscopio y Fossil.

También hemos usado nuestro modesto y acogedor hackerspace, HackBo, como lugar de creación grupal, pues a pesar de que escribo este prólogo como individuo, esta versión del Manual es el resultado de un trabajo colectivo, no sólo de los autores originales, sino de la pequeña comunidad de práctica, sin la cual la obra que usted tiene ante sí, no sería posible. Con Silvia Buitrago, David Salvador, Eduardo Riesco, David y Leonardo Ramírez-Ordoñez, y Gloria Meneses, aprovechamos la naturaleza amoldable de Grafoscopio y lo usamos y extendimos para adecuarlo particularmente a crear esta versión del manual: conversando de algoritmos, escribiendo código para los scrappers y conversores de formatos (de HTML a Markdown), editando y adecuando los textos, tomando café y cerveza, bailando una que otra vez, e incluso participando de manera remota, durante los varios encuentro que hicimos para adaptar el manual.

Espero que ustedes disfruten leyendo el Manual tanto como nosotros disfrutamos adaptándolo, y ahora que tienen el código fuente disponible, que se animen a cambiarlo y adaptarlo aún más y compartirlo de vuelta (que se gocen la fiesta y pongan lo suyo en ella!) En la página web de Grafoscopio y el repositorio de este Manual encontrarán médios para unírsenos.

La invitación y el código fuente quedan, pues, abiertos.

Offray Luna Oct 1, 2017

Actualizaciones, aportes y revisiones

Esta es la primera versión de código abierto del Manual de Periodismo de Datos y aún hay pequeños detalles por corregir, particularmente en las referencias y enlaces internos. Queríamos, sin embargo, trazar una fecha límite que coincidiera con el cronograma establecido por los autores de la segunda edición para el llamado a colaboración, como una forma de atender y extender dicho llamado. En lugar de inscribirnos en un formulario web y esperar la aprobación de nuestros nombres, quisimos establecer, de manera proactiva, otra forma de colaborar, que esté disponible de modos más permanentes y vaya en paralelo a los plazos, de modo similar a como las comunidades de software libre y de código abierto, en las que participamos, realizan lanzamientos (releases) periódicos. Por ello, a pesar de que pusimos una fecha límite para lanzar esta versión, seguiremos puliendo y extendiendo es manual, de manera esporádica o activa, dependiendo de la acogida y otras ocupaciones e intereses.

Acá están nuestras indicaciones sobre cómo acercarse a este documento como un objeto mutable y móvil:

- La copia en tu poder está definida, de forma unívoca, por dos items: la versión (usualmente 1.0, siguiendo el snobismo sin sentido de numerlarlo todo "punto cero") y el número de revisión, que es una combinación de números y letras (o alfanumérica), referida a un identificador único del archivo fuente a partir del cual se generó el PDF. La versión y la revisión aparecen en la página de portada del archivo PDF del Manual, acompañados por otros datos como los autores, el título y la licencia de la obra. Ten presente tanto el número de versión como el de revisión cuando uses nuestro sistema de reporte de incidencias, al que nos referimos a continuación.

- La mayoría de cosas ocurren en nuestro repositorio de código fuente, allí podrás:

- Descargar la última versión del Manual y su código fuente, directamente desde la portada.

- Hacer sugerencias vistando primero nuestros boletos existentes sobre incidencias y en caso de que no encuentres la tuya, crear un nuevo boleto de incidencias, reportando errores ortográficos, enlaces rotos o referencias faltantes u otras mejoras posibles. Ten presente mencionar la página específica a la que haces la sugerencia, cuando aplique y, sobre todo, el número de versión y revisión del Manual, en el que se presentó dicha incidencia.

- También puedes usar nuestros canales virtuales de comunicación y si te encuentras cerca, nuestros encuentros cara a cara, como te indicamos en la siguiente sección.

La comunidad de Grafoscopio y el Data Week

Grafoscopio es una herramienta amoldable, libre y de código abierto, que junta narrativas, visualización y activismo de datos, con investigación reproducible, y es la que usamos, adaptamos y extendimos para crear este manual. Como suele ocurrir alrededor de tales herramientas se construye una comunidad de base, que participan activamente en distintos proyectos, (como este) y encuentros (que llamamos Data Week y Data Rodas), y otra extendida, que usualmente está conformada por personas en los canales de virtuales y de participación más esporádica.

La comunidad base de Grafoscopio, está conformada por:

Silvia Buitrago

: Realizadora de Cine y Televisión y Magister en Comunicación con experiencia en docencia, investigación y creación a través de las TIC con diferentes poblaciones. Actualmente adelanta el Doctorado en Ciencias Sociales y Humanas con el apoyo de las Becas Nacionales Colciencias y la Universidad Jorge Tadeo Lozano, institución con la que trabaja como investigadora y docente. En su tesis doctoral busca estudiar desde el enfoque etnográfico iniciativas de apropiación de tecnologías digitales en Colombia, las cuales desde una marginalidad tecnológica, organizativa y de capital, que no se asume como carencia, sino como motor, juegan tácticamente con las lógicas dominantes que las enmarcan.

Offray Vladimir Luna Cárdenas

: Es hacktivista, el autor principal de Grafoscopio, docente, investigador y consultor. Está terminando su doctorado, si los astros se alinean y logra "redondear" el texto y las visualizaciones de la tesis. Disfruta del tiempo con su familia y amigos, aunque no tanto como quisiera, los comics y la ciencia ficción más seguido y de la rumba más esporádicamente.

Gloria Meneses

: Hacktivista, desarrolladora de software y miembro de diferentes comunidades de software libre e Internet Abierto. Autobiógrafa minimalista.

David Ramírez-Ordoñez

: Bibliotecario, profesor y bloguero. Le encantan las sesiones conceptuales abordadas en

los Data Weeks y Data Rodas que alimentan la comunidad de Grafoscopio y ha procurado

mantener un registro gráfico de las sesiones usando ilustraciones, algunas publicadas en

Nomono.co.

Más información y contacto en

Leonardo Ramírez-Ordoñez

: Es el integrante más reciente del grupo. Su estadía fue determinada por el ambiente familiar y

el café ofrecido en las sesiones de exploración del Grafoscopio, el cual ha conviertido en el motor

para asumir nuevos conocimientos y pequeños aportes en los Data Rodas.

Eduardo Riesco

: Activista del software libre y sus implicaciones sociales. Soñador de mapas, a veces sobre el terreno, a veces sobre el teclado. Buscador incansable de nuevas culturas y de sus formas de comunicación. Admirador de Grafoscopio, de su propuesta integral sin concesiones al mainstream y, sobre todo, de su comunidad.

David Salvador

: Es un profesional de la atención humanitaria, convencido de la potencia y necesidad del activismo a través de la tecnología. Colaborador entusiasmado de Grafoscopio; "tanto por la potencia de la herramienta como con la riqueza de la comunidad en crecimiento que hay detrás". David vive la mitad de su tiempo en países que requieren apoyo humanitario.

La comunidad extendida de Grafoscopio, incluye a la comunidad de base y también a miembros antiguos, que ayudaron a prototipar la herramienta y sus dinámicas (y aunque ahora participan de formas menos activas, seguimos contando con ellos). Tenemos dos canales principales de comunicación:

Esta es una comunidad abierta y alentamos compartir experticias e inquietudes en nuestros diversos encuentros cara a cara y canales digitales. Está cordialmente invitada.

Páginas preliminares {-}

Un trabajo en equipo

El Manual de Periodismo de Datos nació en un taller de 48 horas encabezado por European Journalism Centre y la Open Knowledge Foundation en la MozFest 2011 en Londres. Luego se amplió, convirtiéndose en un esfuerzo internacional en colaboración, que contó con la participación de docenas de los principales representantes del periodismo de datos y sus mejores exponentes.

En los 6 meses siguientes que pasaron entre el comienzo del libro y su primera presentación, cientos de personas contribuyeron de diversas maneras. Si bien hicimos nuestro mejor esfuerzo para reflejar a todos, hemos tenido una cantidad de anónimo, pseudónimos y editores imposibles de rastrear.

A todos los que aportaron y no aparecen en la lista, les decimos dos cosas. Primero, gracias. Segundo. Pueden por favor decirnos quiénes son de modo de poder darles el crédito que se merecen.

Contribuyentes

Las siguientes personas redactaron o contribuyeron directamente en la redacción de los textos en la actual versión del libro (y las ilustraciones son de la diseñadora gráfica Kate Hudson):

- Gregor Aisch, Open Knowledge Foundation

- Brigitte Alfter, Journalismfund.eu

- David Anderton, Periodista freelance

- James Ball, The Guardian

- Caelainn Barr, Citywire

- Mariana Berruezo, Hacks/Hackers Buenos Aires

- Michael Blastland, Periodista freelance

- Mariano Blejman, Hacks/Hackers Buenos Aires

- John Bones, Verdens Gang

- Marianne Bouchart, Bloomberg News

- Liliana Bounegru, European Journalism Centre

- Brian Boyer, Chicago Tribune

- Paul Bradshaw, Birmingham City University

- Wendy Carlisle, Australian Broadcasting Corporation

- Lucy Chambers, Open Knowledge Foundation

- Sarah Cohen, Duke University

- Alastair Dant, the Guardian

- Helen Darbishire, Access Info Europe

- Chase Davis, Center for Investigative Reporting

- Steve Doig, Walter Cronkite School of Journalism, Arizona State University

- Lisa Evans, The Guardian

- Tom Fries, Bertelsmann Stiftung

- Duncan Geere, Wired UK

- Jack Gillum, Associated Press

- Jonathan Gray, Open Knowledge Foundation

- Alex Howard, O’Reilly Media

- Bella Hurrell, BBC

- Nicolas Kayser-Bril, Journalism++

- John Keefe, WNYC

- Scott Klein, ProPublica

- Alexandre Léchenet, Le Monde

- Mark Lee Hunter, INSEAD

- Andrew Leimdorfer, BBC

- Friedrich Lindenberg, Open Knowledge Foundation

- Mike Linksvayer, Creative Commons

- Mirko Lorenz, Deutsche Welle

- Esa Mäkinen, Helsingin Sanomat

- Pedro Markun, Transparência Hacker

- Isao Matsunami, Tokyo Shimbun

- Lorenz Matzat, OpenDataCity

- Geoff McGhee, Stanford University

- Philip Meyer, Professor Emeritus, University of North Carolina at Chapel Hill

- Claire Miller, WalesOnline

- Cynthia O’Murchu, Financial Times

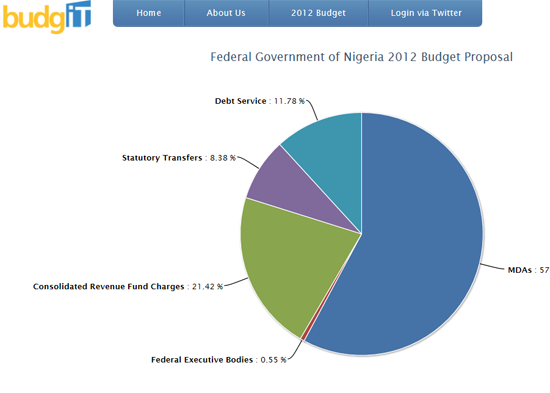

- Oluseun Onigbinde, BudgIT

- Djordje Padejski, Knight Journalism Fellow, Stanford University

- Jane Park, Creative Commons

- Angélica Peralta Ramos, La Nacion (Argentina)

- Cheryl Phillips, The Seattle Times

- Aron Pilhofer, New York Times

- Lulu Pinney, Diseñador infógrafo freelance

- Paul Radu, Organised Crime and Corruption Reporting Project

- Simon Rogers, The Guardian

- Martin Rosenbaum, BBC

- Amanda Rossi, Amigos de Januária

- Martin Sarsale, Hacks/Hackers Buenos Aires

- Fabrizio Scrollini, London School of Economics and Political Science

- Sarah Slobin, Wall Street Journal

- Sergio Sorin, Hacks/Hackers Buenos Aires

- Jonathan Stray, The Overview Project

- Brian Suda, (optional.is)

- Chris Taggart, OpenCorporates

- Jer Thorp, The New York Times R&D Group

- Andy Tow, Hacks/Hackers Buenos Aires

- Luk N. Van Wassenhove, INSEAD

- Sascha Venohr, Zeit Online

- Jerry Vermanen, NU.nl

- César Viana, University of Goiás

- Farida Vis, University of Leicester

- Pete Warden, Independent Data Analyst and Developer

- Chrys Wu, Hacks/Hackers

Lo que este libro es (y lo que no es)

Este libro busca ser un recurso útil para aquellos interesados en convertirse en periodistas de datos o que simplemente quieran tomarlo como un pasatiempo.

Muchas personas contribuyeron a su escritura, y a través de nuestra edición hemos tratado de hacer que se reflejen sus distintas voces y visiones. Esperamos que su lectura resulte una conversación rica e informativa respecto de lo que es el Periodismo de Datos, por qué es importante, y cómo hacerlo.

Lamentablemente, leer este libro no le proveerá un repertorio general de conocimientos y capacidades que necesitará para convertirse en periodista de datos. Esto requeriría una vasta biblioteca manejada por cientos de expertos capaces de responder preguntas sobre cientos de temas. Por suerte, tal biblioteca existe; se llama Internet. En cambio, esperamos que este libro lo oriente sobre cómo iniciarse y dónde mirar si quiere avanzar. Los ejemplos y tutoriales son ilustrativos más que exhaustivos.

Consideramos muy afortunado haber contado con tanto tiempo, energía y paciencia de todos nuestros contribuyentes y nos hemos esforzado por aprovecharlo de la mejor manera. Esperamos que –además de ser una fuente de referencia útil- el libro ayude a documentar la pasión y el entusiasmo, la visión y la energía de un movimiento en crecimiento. El libro intenta mostrar lo que sucede tras bambalinas, las historias detrás de los artículos.

El Manual de Periodismo de Datos es una obra en progreso. Si cree que algo necesita ser corregido o está notoriamente ausente, por favor indíquelo para su inclusión en la siguiente versión. También está disponible gratuitamente bajo una licencia Creative Commons de Atribución Compartir bajo la misma Licencia y lo alentamos fuertemente a que lo comparta con quien crea que puede interesarse en su lectura.

Liliana Bounegru (@bb_liliana)* *Lucy Chambers (@lucyfedia)* *Jonathan Gray (@jwyg) March 2012

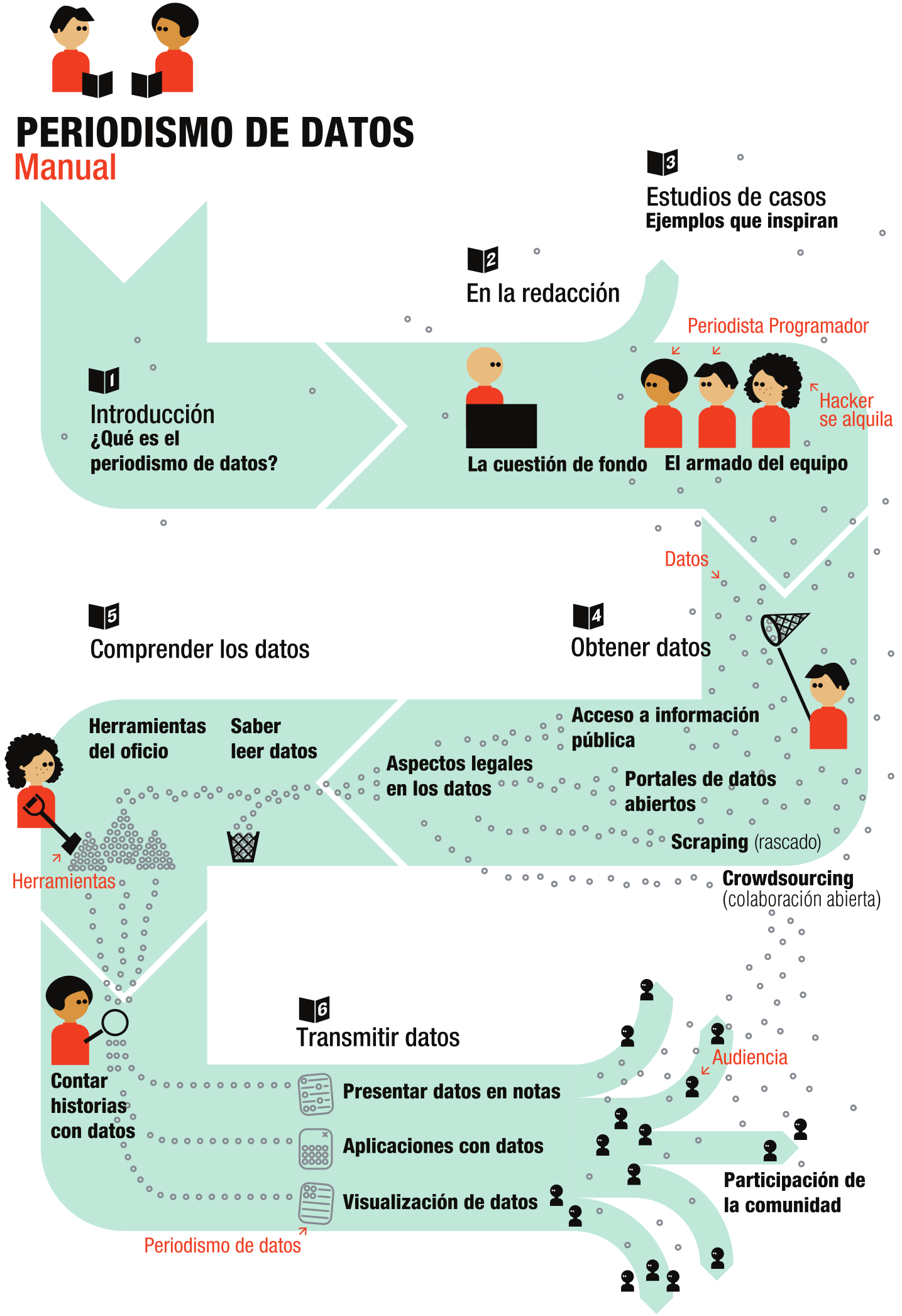

El Manual de un vistazo

Este manual a un vistazo: la infografista Lulu PInney creó este magnífico afiche, que da una visión general del contenido del Manual de periodismo de datos

El Manual de Periodismo de Datos puede ser copiado libremente, redistribuido y reusado bajo los términos de la licencia Creative Commons Atribución-CompartirIgual. Los contribuyentes al Manual del Periodimo de Datos retienen el copyright sobre sus contribuciones respectivas y están de acuerdo en publicarlas bajo los términos de esta licencia.

Introducción

¿Qué es el periodismo de datos? ¿Qué potencial tiene? ¿Cuáles son sus límites? ¿De dónde viene? En esta sección analizamos qué es el periodismo de datos y lo que puede significar para las organizaciones de noticias. Paul Bradshaw (Birmingham City University) y Mirko Lorenz (Deutsche Welle) se refieren a la particular importancia de esta nueva disciplina. Destacados periodistas de datos comentan las claves a tener en cuenta y sus ejemplos favoritos. Finalmente Liliana Bounegru (European Journalism Centre) ubica al Periodismo de Datos en un contexto histórico más amplio.

Qué contiene este capítulo?

- ¿Qué es el periodismo de datos?

- Por qué debieran usar datos los periodistas

- ¿Por qué es importante el periodismo de datos?

- Algunos ejemplos favoritos

- El periodismo de datos en perspectiva

¿Qué es el periodismo de datos?

¿Qué es el periodismo de datos? Podría contestar, simplemente, que es periodismo que se hace con datos. Pero eso no es de gran ayuda.

Tanto “datos” como “periodismo” son términos problemáticos. Algunos creen que “datos” es cualquier colección de cifras, por lo general reunidas en una hoja de cálculo. Hace 20 años, esos eran prácticamente los únicos datos que manejaban los periodistas. Pero ahora vivimos en un mundo digital, un mundo en el que casi cualquier hecho puede ser (y casi todo es) descripto con números.

Su carrera profesional, 300.000 documentos confidenciales, las personas que componen su círculo de amigos; todo esto puede ser (y es) descripto con solo dos números: ceros y unos. Fotos, video, y audio; asesinatos, enfermedades, votos políticos, corrupción y mentiras, también descriptos con ceros y unos.

¿Qué es lo que hace que el periodismo de datos sea diferente del resto del periodismo? Quizás sean las nuevas posibilidades que aparecen, cuando se combina el tradicional “olfato para las noticias” y la capacidad de narrar una historia convincente, con la escala y alcance de la información digital disponible en la actualidad.

Y esas posibilidades pueden aparecer en cualquier momento del proceso periodístico: cuando contamos con la programación necesaria para automatizar el proceso de recoger y combinar información proveniente del gobierno municipal, la policía y otras fuentes civiles, como hizo Adrian Holovaty con ChicagoCrime y luego EveryBlock.

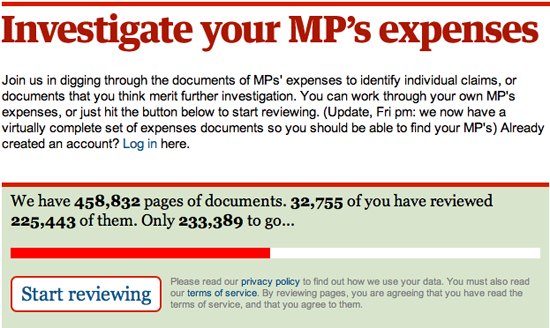

O usar software para encontrar relaciones entre cientos y miles de documentos, tal como hizo The Telegraph con los gastos de los parlamentarios.

El periodismo de datos puede ayudar a un periodista a contar una historia convincente por medio de infografías atractivas. Por ejemplo, las conversaciones espectaculares de Hans Roslign sobre la visualización de la pobreza mundial con Gapminder (que se puede traducir como Recuerdabrecha, n. del t.) han atraído millones de visitas en todo el mundo. Y la obra popular de David McCandless al destilar grandes cifras –tales como poner en contexto el gasto público, o la polución generada por el volcán islandés- muestra la importancia de un diseño claro en Information is Beautiful.

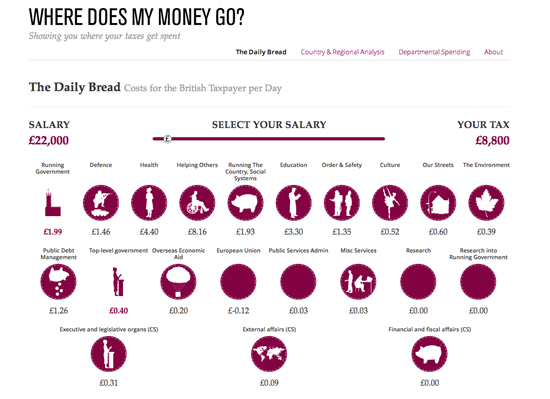

O puede ayudar a explicar cómo se relaciona una historia con un individuo, como hacen ahora la BBC y el Financial Times habitualmente con sus interactivos sobre el presupuesto (donde usted puede averiguar cómo el presupuesto lo afecta en particular a usted en vez de a un genérico “Juan Pueblo”). Y puede abrir el proceso mismo de búsqueda de información, como hace The Guardian de modo tan exitoso al compartir datos, contexto y preguntas en su Datablog.

Los datos pueden ser la fuente del periodismo de datos, o pueden ser la herramienta con la que se narra la historia o ambas cosas. Como cualquier fuente, debe tratarse con escepticismo; y como cualquier herramienta, debemos ser conscientes de cómo puede modelar y limitar las historias que se crean con la misma.

— Paul Bradshaw, Birmingham City University

Por qué debieran usar datos los periodistas

El periodismo está sitiado. En el pasado, como sector, nos basábamos en ser los únicos que operábamos una tecnología para multiplicar y distribuir lo que había pasado de un día al otro. La imprenta servía como puerta de entrada. Cualquiera que quisiera llegar a la gente de una ciudad o una región a la mañana siguiente, recurría a los diarios. Esa era se acabó.

Hoy las noticias fluyen al mismo tiempo que suceden, a través de múltiples fuentes, testigos presenciales y blogs, y lo que ha sucedido es filtrado a través de una vasta red de conexiones sociales, se jerarquiza, se comenta y muy a menudo se ignora.

Por eso el periodismo de datos es tan importante. Reunir, filtrar y visualizar lo que sucede más allá de lo que nos muestran nuestros ojos tiene creciente valor. En la economía global de hoy el jugo de naranja que toma por la mañana, el café que prepara… hay relaciones invisibles entre estos productos, otra gente y usted. El lenguaje de esta red es el de los datos: pequeños puntos de información que a menudo son irrelevantes como instancia individual, pero enormemente importantes cuando se los ve desde el ángulo correcto.

En este momento, unos cuantos periodistas pioneros ya están demostrando cómo se puede usar datos para crear una visión más profunda de lo que sucede a nuestro alrededor y cómo puede afectarnos.

El análisis de datos puede revelar “la forma de una historia” (Sarah Cohen) o proveernos una “nueva cámara” (David McCandless). Usando datos, la tarea de los periodistas pasa de centrarse en ser los primeros en informar, a ser los que nos dicen lo que un proceso podría significar realmente. La gama de temas puede ser amplia. La próxima crisis financiera en ciernes. Los datos económicos detrás de los productos que usamos. El mal uso de fondos o errores políticos, presentados con una visualización convincente que deje poco margen para rebatirla.

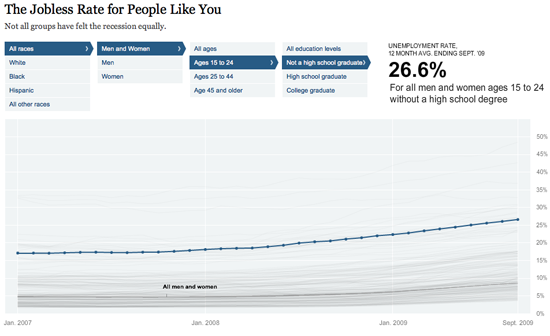

Es por esto que los periodistas debieran ver los datos como una oportunidad. Es posible, por ejemplo, revelar cómo una amenaza abstracta (como el desempleo) afecta a la gente de acuerdo a su edad, su género o su nivel de educación. Usar datos transforma algo abstracto en algo que todos pueden entender y con lo que pueden relacionarse.

Pueden crear herramientas de cálculo personalizadas para ayudar a la gente a tomar decisiones, se trate de comprar un auto o una casa, decidir un rumbo educativo o profesional en su vida, o hacer un control de costos para no meterse en deudas.

Pueden analizar la dinámica de una situación compleja como disturbios o un debate político, mostrar falacias y ayudar a todos a encontrar posibles soluciones para problemas complejos.

Formarse en la búsqueda, depuración y visualización de datos es transformador para la profesión de reunir información también. Los periodistas que dominen esto descubrirán que apoyar sus artículos en datos y la visión que aportan es un alivio. Menos adivinar, menos buscar citas; en vez de ello, un periodista puede crear una posición fuerte apoyada en datos y esto puede afectar mucho el rol del periodismo.

Además, introducirse en el periodismo de datos ofrece una perspectiva para el futuro. Hoy, cuando las redacciones se reducen, la mayoría de los periodistas esperan cambiar el área de las relaciones públicas. Pero los periodistas de datos o los científicos de datos ya son un grupo de profesionales muy solicitados, no solo por los medios. Las empresas e instituciones de todo el mundo buscan “gente que encuentre sentido a las cosas”, y profesionales que sepan cómo revisar datos y convertirlos en algo tangible.

Los datos representan una promesa, y esto es lo que entusiasma a las redacciones, haciéndolas buscar un nuevo tipo de periodista. Para la gente que trabaja por su cuenta, manejar datos ofrece un camino para obtener nuevas oportunidades y un salario estable también. Véalo de este modo: en vez de contratar periodistas que llenen rápidamente páginas y sitios en la red con contenido de bajo valor, el uso de datos podría crear demanda para paquetes interactivos, que solo pueden crearse invirtiendo una semana entera en resolver una cuestión. Esto es un cambio positivo para muchos sectores de los medios.

Hay una barrera que impide a los periodistas usar este potencial: la necesidad de capacitarse para trabajar con datos en todos los pasos, desde una primera pregunta hasta un gran impacto periodístico basado en datos.

Trabajar con datos es como introducirse en un territorio vasto y desconocido. A primera vista los datos crudos resultan inteligibles para los ojos y la mente. Tales datos son inmanejables. Es difícil ordenarlos correctamente para su visualización. Se necesita periodistas experimentados, que tengan la energía como para analizar datos crudos a menudo confusos o aburridos y “ver” las historias ocultas allí.

— Mirko Lorenz, Deutsche Welle

El estudio

El European Journalism Centre realizó una encuesta para saber más sobre las necesidades de capacitación de los periodistas. Descubrimos que hay una gran disposición de salir de la postura cómoda del periodismo tradicional, e invertir tiempo para dominar nuevas capacidades. Los resultados de la encuesta demuestran que los periodistas ven la oportunidad, pero necesitan un poco de apoyo para superar los problemas iniciales que les impiden trabajar con daos. Hay confianza de que si el periodismo de datos fuera adoptado de modo más universal, los flujos de trabajo, las herramientas y los resultados mejorarían rápidamente. Pioneros tales como The Guardian, The New York Times, The Texas Tribune, y Die Zeit siguen elevando el nivel con sus artículos basados en datos.

¿El periodismo de datos seguirá siendo el dominio de un pequeño puñado de pioneros o pronto toda organización de noticias tendrá su propio equipo de periodistas dedicados especialmente a los datos. Esperamos que este manual ayude a más periodistas y redacciones a aprovechar este campo emergente.

¿Por qué es importante el periodismo de datos?

Preguntamos a algunos de los principales practicantes y partidarios del periodismo de datos por qué piensan que el periodismo de datos es un desarrollo importante. los datos crudos resultan inteligibles para los ojos y la mente. Esto es lo que dijeron.

Filtrar el flujo de datos

Cuando había escasez de información, la mayor parte de nuestros esfuerzos estaban dedicados a buscarla y reunirla. Ahora que la información es abundante, es más importante el procesamiento. El procesamiento tiene dos niveles: 1) análisis para encontrar sentido y estructura en el flujo sin fin de datos y 2) presentación de esa información para meter lo que es importante y relevante en la cabeza del consumidor. Al igual que la ciencia, el periodismo de datos da a conocer sus métodos y presenta sus descubrimientos de un modo que pueda ser verificado a través de su replicado.

— Philip Meyer, Professor Emeritus, University of North Carolina at Chapel Hill

Nuevos enfoques para narrar historias

El periodismo de datos es un término abarcativo que, para mí, incluye un conjunto de herramientas, técnicas y enfoques de la narrativa siempre crecientes. Puede incluir todo, desde el tradicional periodismo asistido por computadoras (usando datos como una “fuente”) hasta la visualización más avanzada de datos y aplicaciones de noticias. El objetivo unificador es periodístico: proveer información y análisis para ayudar a informarnos todos sobre asuntos importantes de actualidad.

— Aron Pilhofer, New York Times

Como periodismo fotográfico con una laptop

“El periodismo de datos” difiere del “periodismo escrito” solo en que usamos un equipo diferente. Todos nos ganamos la vida olfateando, reportando y relacionando historias. Es como el “periodismo fotográfico”; solo hay que cambiar la cámara por una laptop.

— Brian Boyer, Chicago Tribune

El periodismo de datos es el futuro

El periodismo de datos es el futuro. Los periodistas tienen que saber manejar datos. Hace un tiempo uno descubría cosas hablando con gente en bares, y puede ser que esto siga sucediendo a veces. Pero ahora también se trata de analizar datos, equiparse con herramientas, y analizarla y encontrar lo que es interesante. Tener todo en perspectiva, ayudando a la gente a ver cómo encajan las piezas (para no repetir todo), y qué pasa en el país.

— Tim Berners-Lee, founder of the World Wide Web

El procesamiento de cifras se une al pulido del lenguaje

El periodismo de datos es tender un puente para superar la brecha entre los técnicos estadísticos y los cinceladores de palabras. Ubicar cosas destacadas e identificar tendencias que no solo son significativas estadísticamente sino que también son relevantes para desentrañar el mundo de hoy, que es intrínsecamente complejo.

— David Anderton, freelance journalist

Actualizar sus capacidades

El periodismo de datos implica un nuevo conjunto de habilidades para buscar, comprender y visualizar fuentes digitales, en una época en que las capacidades básicas del periodismo tradicional ya no bastan. No lo reemplaza, le agrega cosas.

En un momento en que las fuentes se están volviendo digitales, los periodistas pueden y tienen que estar más en contacto con estas fuentes. Internet abrió posibilidades que van más allá de lo que podemos entender hoy. El periodismo de datos es solo el comienzo de la evolución de nuestras prácticas pasadas para adaptarse al online.

El periodismo de datos sirve a dos importantes propósitos para las organizaciones de noticiosas: encontrar historias únicas (no de los cables) y ejecutar la función de alerta. Especialmente en tiempos de crisis financieras, estos objetivos son importantes para los diarios.

Desde el punto de vista de un diario regional, el periodismo de datos es crucial. Existe el dicho: “una teja floja en su casa se considera más importante que disturbios en un país lejanos”. A uno lo golpea en la cara e impacta en su vida de modo más directo. Al mismo tiempo, la digitalización está en todas partes. Debido a que los diarios locales tienen este impacto directo en su vecindario y las fuentes se vuelven digitalizadas, un periodista debe saber cómo encontrar, analizar y visualizar una historia a partir de datos.

— Jerry Vermanen, NU.nl

Un remedio para la asimetría de la información

La asimetría de la información –no la falta de información sino la incapacidad de absorberla y procesarla a la velocidad y con el volumen que nos llega- es uno de los problemas más significativos que enfrentan los ciudadanos al elegir cómo vivir sus vidas. La información tomada de medios impresos, visuales y radiales influye en las opciones y las acciones de los ciudadanos. El buen periodismo de datos ayuda a combatir la asimetría de la información.

— Tom Fries, Bertelsmann Foundation

Una respuesta a las relaciones públicas basadas en datos

La disponibilidad de herramientas de medición y sus precios decrecientes –en una combinación auto-sustentada que se concentra en el desempeño y la eficiencia en todos los aspectos de la sociedad- han llevado a quienes toman las decisiones a cuantificar los avances de sus políticas, monitorear tendencias e identificar oportunidades.

Las compañías continuamente encuentran nuevas mediciones que muestran su buen desempeño. A los políticos les encanta alardear de las cifras sobre reducción de desempleo y crecimiento del PBI. La falta de conocimientos por parte de los periodistas respecto de los escándalos de Enron, Worldcom, Madoff o Solyndra es prueba de la incapacidad de muchos profesionales de ver más allá de las cifras. Hay una tendencia a aceptar las cifras más que otros datos, ya que tienen un aura de seriedad, aunque sean completamente inventadas.

El saber manejar datos ayudará a los periodistas a aguzar su sentido crítico al enfrentar cifras, y ojalá que les sirva para avanzar un poco en su relación con los departamentos de RRPP.

— Nicolas Kayser-Bril, Journalism++

Proveer interpretaciones independientes de información oficial

Luego del terremoto devastador y el subsecuente desastre de la planta nuclear de Fukushima en 2011, la importancia del periodismo de datos se ha hecho claro para la gente de medios en Japón, país que en general va a la zaga en materia de periodismo digital.

Quedamos a la deriva cuando el gobierno y los expertos no tuvieron datos creíbles acerca de los daños. Cuando los funcionarios ocultaron al público los datos SPEEDI (predicción de difusión de materiales radioactivos), no estábamos en condiciones de decodificarlos aunque se hubiesen filtrado. Voluntarios comenzaron a reunir datos sobre radioactividad usando sus propios recursos, pero no estábamos armados con conocimientos estadísticos, de interpolación, de visualización y demás. Los periodistas tienen que tener acceso a los datos en crudo y aprender a no depender de las interpretaciones oficiales de los mismos.

— Isao Matsunami, Tokyo Shimbun

Manejar el diluvio de datos

Los desafíos y las oportunidades que presenta la revolución digital siguen complicando al periodismo. En una era de abundancia de información, los periodistas y los ciudadanos necesitan mejores herramientas, se trate de curar los samizdat del siglo XXI en Medio Oriente, procesar una avalancha de datos difundidos a medianoche, o encontrar la mejor manera de visualizar la calidad del agua en una nación. Al debatirnos con los desafíos del consumo que presenta este diluvio de datos, las nuevas plataformas de edición también están dando a todos el poder de reunir y compartir datos digitalmente, convirtiéndolos en información. Mientras los periodistas y editores han sido los vectores tradicionales de la colecta y diseminación de información, el ambiente horizontal de información ahora hace que las noticias se conozcan primero online y no en las redacciones.

En todo el planeta, de hecho, el vínculo entre los datos y el periodismo se está fortaleciendo. En una era de grandes cantidades de datos, la creciente importancia del periodismo de datos está en la capacidad de sus practicantes de dar contexto, claridad y –quizás lo más importante, encontrar la verdad en la cantidad en expansión de contenido digital en el mundo. Eso no significa que las organizaciones de medios integradas de hoy no tengan un rol crucial. Lejos de ello. En la era de la información, se necesita más que nunca a los periodistas para curar, verificar, analizar y sintetizar los datos. En ese contexto, el periodismo de datos tiene una profunda importancia para la sociedad.

Hoy, encontrarle sentido a los grandes volúmenes de datos, en particular los datos no estructurados, serán un objetivo central de los científicos de todo el mundo, trabajen en salas de redacción, Wall Street o Silicon Valley. Notoriamente esa meta se verá facilitada sustancialmente por un conjunto creciente de herramientas comunes, sean empleadas por tecnólogos del estado, tecnólogos de la salud o desarrolladores de las redacciones.

— Alex Howard, O’Reilly Media

Nuestras vidas son datos

El buen periodismo de datos es difícil, porque el buen periodismo es difícil. Significa cómo obtener los datos, cómo entenderlos, y cómo encontrar la historia. A veces hay callejones sin salida, y a veces no hay una gran historia. Al fin de cuentas, si solo fuera cuestión de apretar el botón indicado, no sería periodismo. Pero eso es lo que hace que valga la pena –en un mundo en el que nuestras vidas cada vez son más datos-, que sea esencial para una sociedad libre y justa.

— Chris Taggart, OpenCorporates

Una manera de ahorrar tiempo

Los periodistas no tienen tiempo para perder transcribiendo cosas a mano y complicarse tratando de obtener información de archivos PDF, por lo que aprender un poco de código (o saber dónde buscar gente que puede ayudar) es increíblemente valioso.

Un periodista de Folha do Sāo Paulo estaba trabajando con el presupuesto local y me llamó para agradecernos por publicar online las cuentas de la municipalidad de Sāo Paulo (2 días de trabajo para un solo hacker). Dijo que las había estado transcribiendo a mano los últimos 3 meses, tratando de encontrar una historia. También recuerdo haber resuelto un “problema de PDF” para Contas Abertas, una organización que monitorea noticias parlamentarias: 15 minutos y 15 líneas de código, en vez de un mes de trabajo.

— Pedro Markun, Transparência Hacker

Una parte esencial del herramental del periodista

Creo que es importante destacar el aspecto “periodístico” o de reportero del “periodismo de datos. El ejercicio no debiera ser analizar o visualizar datos por el gusto de hacerlo, sino utilizarlo como herramienta de modo de aproximarnos más a la verdad de lo que sucede en el mundo. Veo la capacidad de analizar e interpretar datos como parte esencial del set de herramientas actual de los periodistas, en vez de una disciplina por separado. Al fin de cuentas, todo tiene que ver con el buen periodismo y contar historias del modo más apropiado.

El periodismo de datos es otra manera de analizar el mundo y hacer que los poderes constituidos rindan cuentas. Con una creciente cantidad de datos disponible, ahora es más importante que nunca que los periodistas sean conscientes de las técnicas del periodismo de datos. Esta debe ser una herramienta que cualquier periodista debiera incorporar, se trate de aprender cómo trabajar directamente con datos, o a colaborar con alguien que lo pueda hacer.

Su verdadero potencial está en ayudarlo a obtener información que de otro modo sería muy difícil de encontrar o demostrar. Un buen ejemplo es la historia de Steve Doig que analizó patrones de daños del huracán Andrew. Unió dos conjuntos distintos de datos: uno que mapeaba el nivel de destrucción causado por el huracán, y otro que muestra las velocidades de los vientos. Esto le permitió señalar áreas en las cuales las malas prácticas en la construcción de edificios contribuyeron/intensificaron el impacto del desastre. Ganó por la historia un Pulitzer Prize en 1993 y sigue siendo un gran ejemplo de lo que es posible.

Idealmente se usan los datos para descubrir cosas destacadas, sorprendentes o áreas de interés. En este sentido, actúan como pistas. Si bien las cifras pueden ser interesantes, no basta escribir solamente sobre datos. Hay que hacer el trabajo de periodista para explicar qué significan.

— Cynthia O’Murchu, Financial Times

Adaptarse a cambios en nuestro ambiente de información

Las nuevas tecnologías digitales generan nuevas maneras de producir y diseminar el conocimiento en la sociedad. El periodismo de datos puede entenderse como el intento de los medios de adaptarse y responder a los cambios en el ambiente de la información, incluyendo maneras de contar historias más interactivas y multidimensionales, que permite a los lectores explorar las fuentes que subyacen a las noticias, alentándolos a participar en el proceso de crear y evaluar historias.

— César Viana, University of Goiás

Una manera de ver cosas que de otro modo podría no ver

Algunas historias sólo pueden entenderse y explicarse analizando –y a veces visualizando- datos. Las relaciones entre personas o entes poderosos quedarían sin revelar, las muertes causadas por políticas farmacéuticas permanecerían ocultas, las políticas ambientales que dañan el medio continuarían sin límite. Pero cada una de estas situaciones han podido modificarse gracias a los datos obtenidos, analizados y aportados por los periodistas a los lectores. Los datos pueden ser simples como una planilla de cálculo, o un registro de llamadas telefónicas, o complejos como los resultados de pruebas escolares o datos de infecciones hospitalarias; como sea, allí hay historias que vale la pena contar.

— Cheryl Phillips, The Seattle Times

Una manera de enriquecer los artículos

Podemos pintar cuadros de nuestras vidas completas con nuestro rastro digital. Desde lo que consumimos y navegamos, hasta donde y cuando viajamos, nuestras preferencias musicales, nuestros primeros amores, los hitos de nuestros hijos, incluso nuestros últimos deseos, todo puede ser rastreado, digitalizado, almacenado en la nube y difundido.**Este universo de datos puede ser sacado a la superficie para narrar historias, responder preguntas e impartir una comprensión de la vida de maneras que actualmente superan incluso la más rigurosa y cuidadosa reconstrucción de anécdotas.

— Sarah Slobin, Wall Street Journal

No se necesitan nuevos datos para tener una primicia

A veces los datos ya son públicos y están disponibles, pero nadie los ha analizado atentamente. En el caso del informe de Associated Press sobre 4500 páginas de documentos desclasificados que describen las acciones de contratistas de seguridad privados durante la guerra de Irak, el material fue obtenido por un periodista independiente a lo largo de varios años, usando pedidos de Acceso a la Información dirigidos al departamento de Estado de EE.UU. Escanearon los resultados impresos y los subieron a DocumentCloud, lo que nos permitió hacer nuestro análisis general.

— Jonathan Stray, The Overview Project

Algunos ejemplos favoritos

Le preguntamos a algunos de nuestros colaboradores acerca de sus ejemplos favoritos de periodismo de datos y qué les gusta de los mismos. Sus respuestas, a continuación:

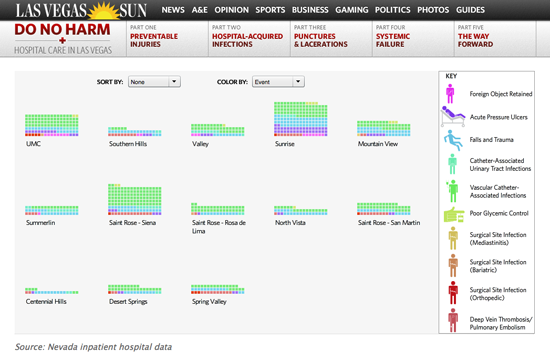

No causar daño, en el Las Vegas Sun

Mi ejemplo favorito es la serie No causar daño de 2010 en Las Vegas Sun, sobre la atención en los hospitales. El Sun analizó más de 2.900.000 de registros de aranceles hospitalarios, que revelaron más de 3600 lesiones, infecciones y errores quirúrgicos evitables. Obtuvieron datos a través de un pedido de acceso a archivos públicos e identificaron más de 300 casos en que los pacientes murieron por errores que pudieron haberse prevenido. Contiene distintos elementos, incluyendo un gráfico interactivo que permite al lector ver (por hospital) donde se dieron lesiones quirúrgicas más a menudo de lo esperado; un mapa con un cronograma que muestra cómo se extienden las infecciones hospital por hospital; y un gráfico interactivo que permite a los usuarios ordenar los datos por lesiones evitables o por hospital, para ver dónde la gente se ve afectada. Me gusta porque es muy fácil de entender y navegar. Los usuarios pueden explorar los datos de manera muy intuitiva.

Además tuvo un impacto real: la legislatura de Nevada respondió con 6 legislaciones. Los periodistas involucrados trabajaron muy duro para obtener y desmenuzar los datos. Uno de los periodistas, Alex Richards, envió los datos a los hospitales y al Estado al menos una docena de veces para lograr que se corrigieran los errores.

— Angélica Peralta Ramos, La Nación (Argentina)

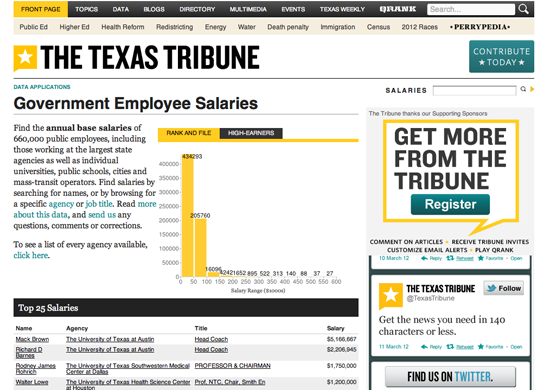

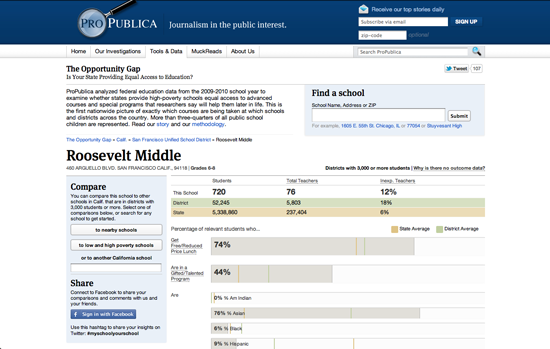

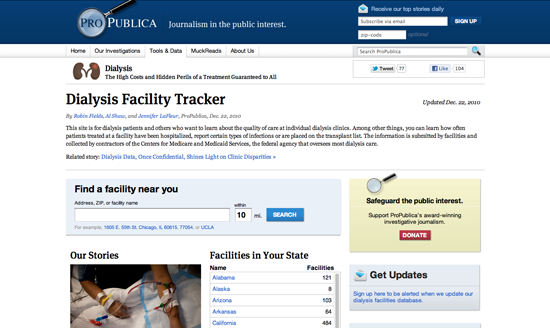

Base de datos de salarios de empleados del Estado

Me encanta el trabajo que pequeñas organizaciones independientes realizan todos los días tales como ProPublica o el Texas Tribune, que tiene a Ryan Murphy como gran periodista de datos. Si tuviera que elegir, optaría por el proyecto de base de datos de Salarios de Empleados del Estado del Texas Tribune. Este proyecto reúne en una base de datos la información de los salarios de 660.000 empleados estatales para que los usuarios busquen y ayuden a generar historias. Se puede buscar por ente estatal, nombre o salario. Es simple, significativo y pone a disposición del público información hasta ahora inaccesible. Es fácil de usar y genera historias de manera automática. Es un gran ejemplo que muestra por qué el Texas Tribune concentra la mayor parte de su tráfico en sus páginas de datos.

— Simon Rogers, The Guardian

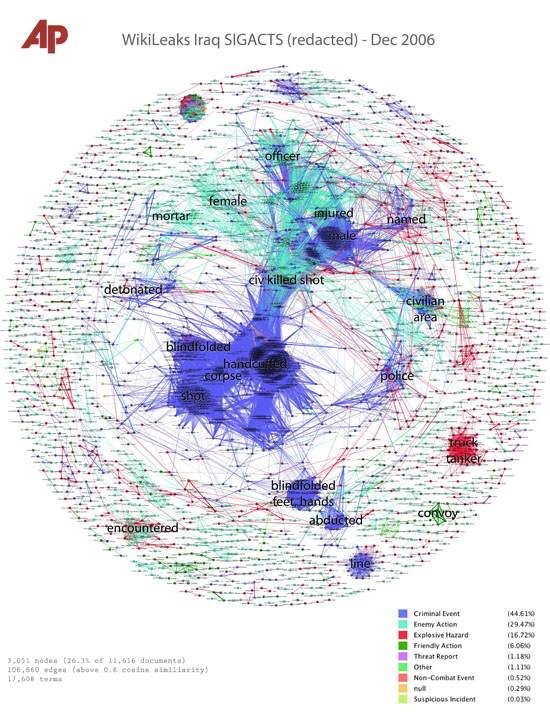

Visualización de texto completo de los registros de la guerra de Irak, Associated Press

El trabajo de Jonathan Stray y Julian Burgess sobre los registros (logs) de la Guerra de Irak es una llamativa incursión en el análisis de texto y la visualización, utilizando técnicas experimentales para comprender temas que vale la pena explorar, dentro de un gran conjunto de datos en formato texto.

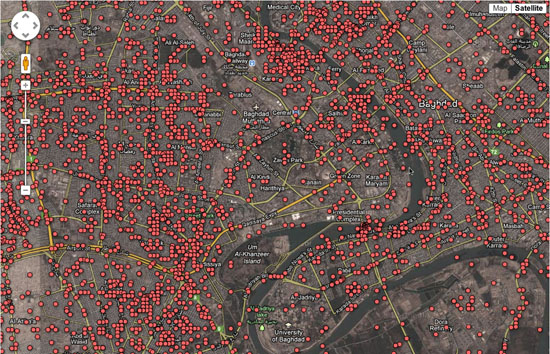

Por medio de técnicas y algoritmos de analítica de textos, Jonathan y Julian crearon un método que muestra concentraciones de palabras clave contenidas en miles de informes del gobierno de Estados Unidos sobre la guerra de Irak, difundido por WikiLeaks, en un formato visual.

Si bien este método tiene limitaciones y el trabajo es experimental, es un enfoque nuevo e innovador. En vez de tratar de leer todos los archivos o revisar los registros de guerra con una noción preconcebida de lo que puede encontrarse ingresando palabras claves y revisando el resultado, esta técnica calcula y visualiza temas/palabras clave de particular relevancia.

Con crecientes cantidades de datos en formato texto (emails, informes, etc.) y numérico llegando al dominio público, encontrar maneras de determinar áreas de interés clave se volverá cada vez más importante. Es un sub-campo interesante del periodismo de datos.

— Cynthia O’Murchu, Financial Times

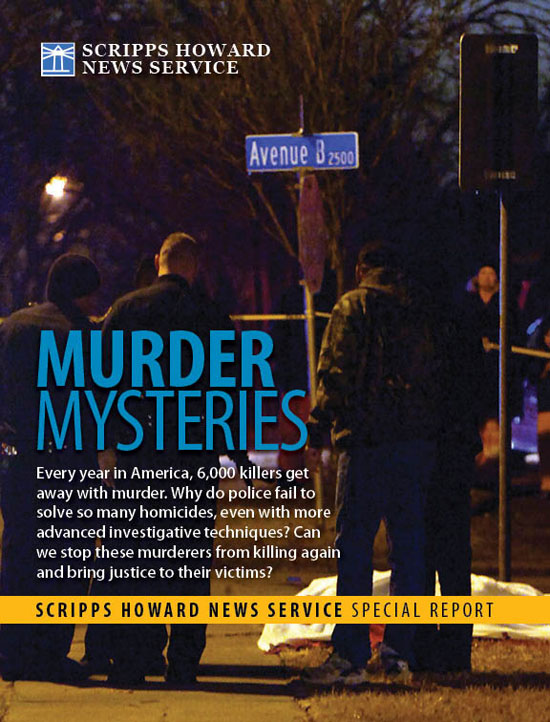

Misterios de Asesinatos

Una de mis piezas favoritas de periodismo de datos es el proyecto de Misterios de Asesinatos, por Tom Hargrove del Scripss Howard News Service. A partir de datos oficiales y pedidos de acceso a registros públicos, creó una base de datos, que incluye el detalle demográfico de más de 185.000 asesinatos no resueltos, y luego diseñó un algoritmo para buscar patrones que sugieran la posible presencia de asesinos seriales.

Este proyecto tiene todo: un gran trabajo, una base de datos mejor que la del estado, análisis inteligente usando técnicas de ciencias sociales, y una presentación interactiva de datos online de modo que los lectores puedan explorar por su cuenta.

— Steve Doig, Walter Cronkite School of Journalism, Arizona State University

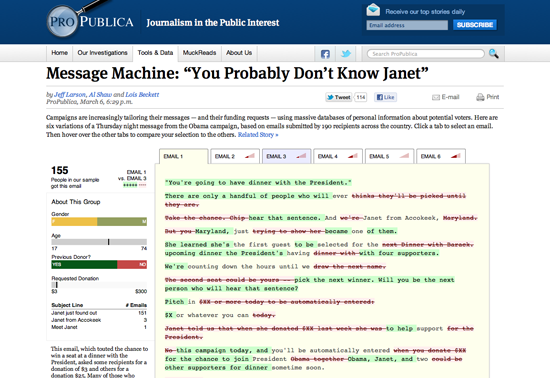

Máquina de Mensajes

Me encanta la historia de Máquina de Mensajes de ProPublica y su blog nerd. Todo comenzó cuando un grupo de tuiteros expresó curiosidad por haber recibido correos electrónicos diferentes de la campaña de Barack Obama. La gente de ProPublica tomó nota y pidió a su público que reenviaran los correos que recibieran de la campaña. La presentación es elegante, un análisis diferencial visual de varios correos diferentes que fueron enviados esa noche. Es admirable porque recogieron sus propios datos (una pequeña muestra, pero lo suficiente como para contar la historia). Pero es aún más admirable porque cuenta la historia de un fenómeno en curso: gran cantidad de datos utilizados en campañas políticas para dirigir mensajes a individuos específicos. Es sólo un anticipo de cosas por venir.

— Brian Boyer, Chicago Tribune

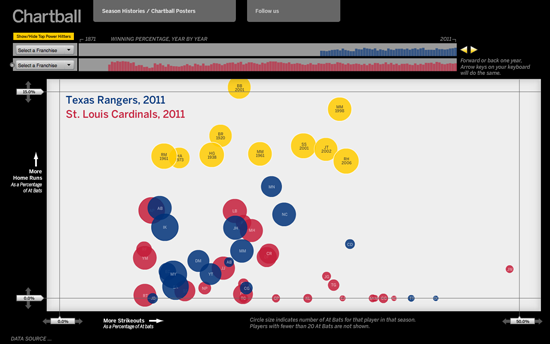

Chartball

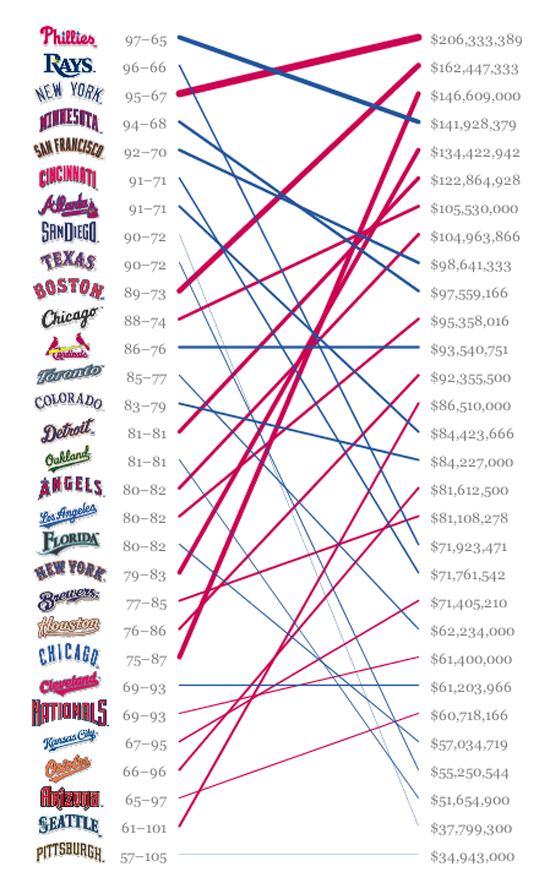

Uno de mis proyectos de periodismo de datos favoritos es el trabajo de Andrew García Phillips sobre http://www.chartball.com/Chartball. Andrew es fanático de los deportes con un voraz apetito de datos, un ojo tremendo para el diseño y la capacidad de escribir código. En Chartball no solo visualiza el conjunto de la historia, sino que detalla los éxitos y fracasos de jugadores individuales y equipos. Ofrece contexto, un gráfico atractivo y su trabajo es profundo, divertido e interesante, y a mí ni siquiera me interesan demasiado los deportes.

— Sarah Slobin, Wall Street Journal

El periodismo de datos en perspectiva

En agosto de 2010 algunos colegas del European Journalism Centre y yo organizamos lo que creemos que fue una de las primeras conferencias internacionales de periodismo de datos, que se realizó en Ámsterdam, Holanda. En aquel momento no había mucha discusión respecto del tema, y solo había un par de organizaciones conocidas ampliamente por su labor en esta área.

La manera en que organizaciones de noticias como The Guardian y el New York Times manejaron las grandes cantidades de datos difundidos por WikiLeaks, es uno de los grandes casos que impulsaron el término. En aquel momento el concepto comenzó a tener un uso más amplio (junto con “el periodismo asistido por computadora”) para describir cómo los periodistas utilizaban datos para mejorar su cobertura y amplificar investigaciones profundas de un tema dado.

Hablando con periodistas de datos y estudiosos del periodismo on Twitter, parecería que una de las formulaciones más tempranas de lo que ahora reconocemos como periodismo de datos, en 2006 por Adrian Holovaty, fundador de EveryBlock, un servicio de información que permite a los usuarios saber lo que ha estado sucediendo en su área, en su manzana. En su breve ensayo “Un modo fundamental en que los sitios de diarios tienen que cambiar”, sostiene que los periodistas deben publicar datos estructurados procesables por la computadora, junto con el “gran bodoque de texto” tradicional:

Por ejemplo, digamos que un diario ha escrito una historia sobre un incendio local. Poder leer la historia en un celular está bien. Viva la tecnología. Pero lo que realmente quiero poder hacer es explorar los datos en crudo de esa historia, uno por uno, con capas de atribuciones, y una infraestructura para comparar detalles del incendio con incendios anteriores: fecha, momento, lugar, victimas, número de la central de bomberos, distancia de la central de bomberos, nombres y años de experiencia de los bomberos que actuaron, el tiempo que les llevó a los bomberos llegar, e incendios posteriores, cuando sea que sucedan.

¿Pero qué es lo que distingue esto de otras formas de periodismo que usan bases de datos o computadoras? ¿Cómo y en qué medida el periodismo de datos es distinto de otras formas de periodismo del pasado?

Periodismo Asistido por Computadora y Periodismo de Precisión

Usar datos para mejorar los informes y presentar información estructurada (aunque no sea legible por la computadora) al público tiene una larga historia. Quizás lo más relevante en forma inmediata para lo que ahora llamamos periodismo de datos es el periodismo asistido por computadora, conocido por la sigla CAR, que fue el primer abordaje organizado y sistemático del uso de computadoras para recoger y analizar datos de modo de mejorar las noticias.

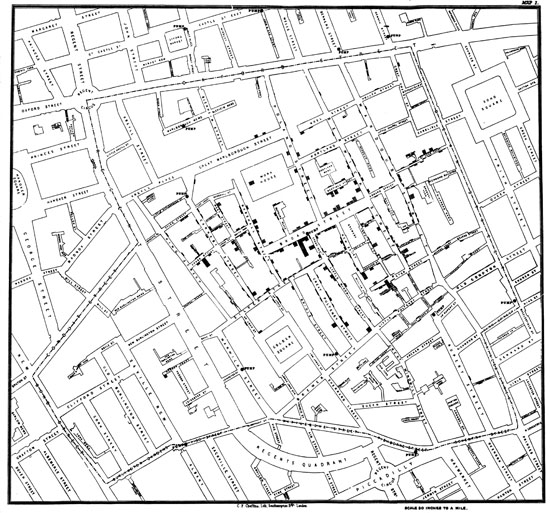

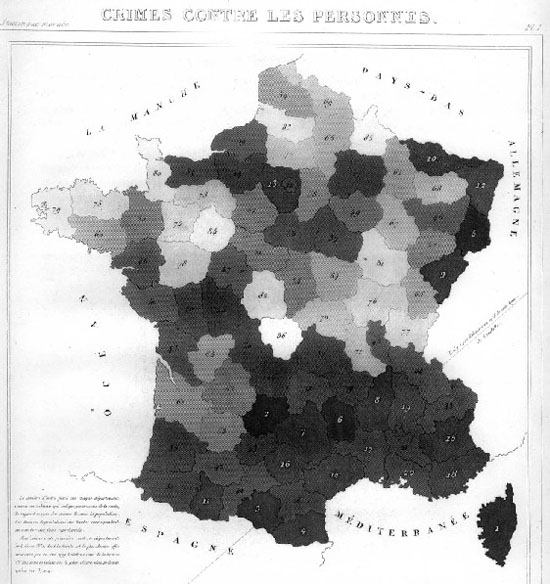

El CAR fue usado por primera vez en 1952 por CBS para predecir los resultados de la elección presidencial. Desde la década del ‘60 periodistas (en su mayoría de investigación y de Estados Unidos) han buscado controlar el poder de modo independiente analizado bases de datos de registros públicos con métodos científicos. También conocido como “periodismo de servicio público” los partidarios de estas técnicas con ayuda de computadoras han buscado revelar tendencias, demostrar la falsedad de creencias populares y revelar injusticias perpetradas por autoridades y corporaciones privadas. Por ejemplo, Philip Meyer trató de demostrar la falsedad de los informes de los disturbios en Detroit de 1967, para reflejar que no eran solo sureños poco educados los que participaban. Las historias de Bill Dedman sobre “El Color del Dinero” en la década del ‘80 reveló prejuicios raciales sistémicos en las políticas de crédito de las principales instituciones financieras. En su artículo “Lo Que Salió Mal” Steve Doig buscó analizar los patrones de daños del huracán Andrew a comienzos de la década del ‘90, para comprender el efecto de las políticas y prácticas de desarrollo urbanas fallidas. Los reportes basados en datos han generado valiosos servicios al público y permitido a los periodistas ganar importantes premios.

A comienzos de la década del ‘70 el término periodismo de precisión fue acuñado para describir este tipo de recolección de noticias: “la aplicación de métodos de investigación de las ciencias sociales y de la conducta a la práctica del periodismo” (de “The New Precision Journalism”, por Philip Meyer). Se creó el periodismo de precisión para que fuera practicado en las principales instituciones de medios por profesionales formados en periodismo y ciencias sociales. Nació en respuesta al “nuevo periodismo”, una forma de periodismo en el que las técnicas del periodismo se aplican a las noticias. Meyer sugiere que lo que se necesita son técnicas científicas de recolección y análisis de datos, en vez de técnicas literarias, para que el periodismo pueda cumplir con su cometido de objetividad y verdad.

Se puede entender el periodismo de precisión como una reacción frente a algunas de las fallas y debilidades comúnmente citadas: la dependencia de informes de prensa (lo que se describió luego como “churnalismo”), el prejuicio en favor de fuentes autorizadas, etc. Meyer ve que estas debilidades derivan de la falta de aplicación de técnicas científicas de información y métodos científicos tales como encuestas y registros públicos. En los ‘60, el periodismo de precisión fue utilizado para representar a grupos marginales y sus historias. Según Meyer:

El periodismo de precisión era una manera de expandir el herramental del periodista para hacer que temas antes inaccesibles o sòlo accesibles de modo tosco, estuvieran abiertos a la investigación periodística. Fue especialmente útil para dar voz a grupos minoritarios y disidentes que luchaban por lograr representación.

Un artículo influyente publicado en la década del ‘80 respecto de la relación entre el periodismo y las ciencias sociales se hace eco del discurso sobre el periodismo de datos. Los autores, dos profesores de periodismo estadounidenses, sugieren que en las décadas de los años ‘70 y ‘80, la comprensión del público de lo que son las noticias se amplía, de una concepción más estrecha de “eventos noticiosos” al “reporte situacional” (o informes sobre tendencias sociales). Por ejemplo, al usar bases de datos de censos o encuestas, los periodistas logran “ir más allá de la información de eventos específicos, aislados, para proveer contexto que les da significado”.

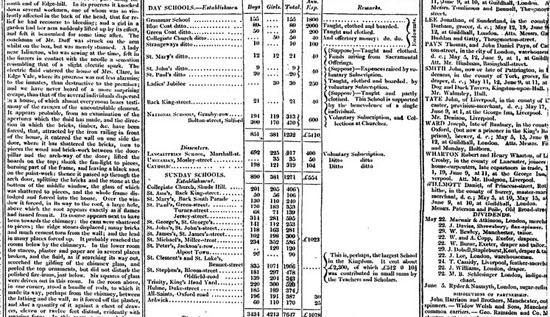

Como era de esperar, la práctica de usar datos para mejorar el periodismo existe desde que hay datos. Como señala Simon Rogers, el primer ejemplo de periodismo de datos en The Guardian data de 1821. Es una tabla de escuelas en Manchester que da la cantidad de estudiantes que asisten a clases y los costos por escuela, Según Rogers, esto ayudó a mostrar el número real de estudiantes que recibían educación gratuita, que era mucho mayor de lo que mostraban las cifras oficiales.

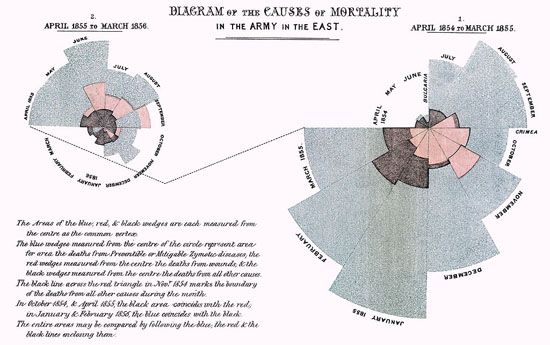

Otro ejemplo temprano en Europa es de Florence Nightingale y su informe clave, "Mortalidad del Ejército Británico", publicado en 1858. En su informe al parlamento usó gráficos para promover mejoras en los servicios de salud para el ejército británico. El más famoso de ellos es su “coxcomb”, una espiral de secciones que representan muertes por mes, en el que se destaca que la gran mayoría de las muertes eran por enfermedades prevenibles, en vez de balas.

Periodismo de Datos y Periodismo Asistido por Computadora

En este momento hay un debate sobre “continuidad y cambio” en torno de la etiqueta de “periodismo de datos” y su relación con prácticas previas periodísticas que emplean técnicas computacionales para analizar conjuntos de datos.

Algunos sostienen que hay una diferencia entre CAR y el periodismo de datos. Dicen que CAR es una técnica para recoger y analizar datos como una manera de fortalecer el periodismo (generalmente de investigación), mientras que el periodismo de datos presta atención a la manera en que los datos se ubican en el conjunto del flujo de trabajo periodístico. En este sentido el periodismo de datos presta tanta –y a veces más- atención a los datos mismos, en vez de usarlos simplemente como un medio para encontrar o dar más fuerza a determinadas historias. De allí que encontremos el Datablog de The Guardian o que el Texas Tribune publica juegos de datos junto con los artículos –o incluso solo juegos de datos por sí mismos- para que la gente analice y explore.

Otra diferencia es que en el pasado los periodistas de investigación se encontraban faltos de información respecto de una pregunta que trataban de contestar, o una cuestión que trataban de abordar. Si bien esto sigue sucediendo, también existe una abundancia abrumadora de información con la que los periodistas a veces no saben qué hacer. No saben cómo obtener valor de los datos. Un ejemplo reciente es el Sistema de Información Online Combinada, la mayor base de datos del Reino Unido de información sobre gasto público. Esta base de datos fue durante mucho tiempo un reclamo de los partidarios de la transparencia, pero dejó confundidos y sin respuesta a muchos periodistas cuando se publicó. Como me escribió recientemente Philip Meyer: “Cuando la información era escasa, la mayor parte de nuestros esfuerzos estaban dedicados a buscarla y recogerla. Ahora que hay información abundante, el procesamiento es más importante”.

Por otro lado, algunos sostienen que no hay ninguna diferencia significativa entre el periodismo de datos y el periodismo asistido por computadoras. A esta altura resulta claro que incluso las prácticas más recientes de los medios más novedosos combinan cosas conocidas desde hace tiempo con algo nuevo. Antes que debatir si el periodismo de datos es completamente nuevo, una postura más fructífera sería considerarlo como parte de una tradición más longeva, pero que responde a nuevas circunstancias y condiciones. Aunque no haya una diferencia en cuanto a metas y técnicas, el surgimiento de la etiqueta “periodismo de datos” al comienzo del siglo indica una nueva fase en la que el mero volumen de los datos libremente disponibles online –combinado con herramientas sofisticadas centradas en el usuario, la auto edición y las herramientas de colaboración abierta (crowdsourcing)- permite a más gente trabajar con más datos de modo más fácil que nunca.

El periodismo de datos tiene que ver con la alfabetización masiva en el manejo de datos.

Las tecnologías digitales y la red están cambiando de modo fundamental la manera en que se edita la información. El periodismo de datos es una parte del ecosistema de herramientas y prácticas que han surgido en torno a los sitios y servicios de datos. El citado y el compartir materiales de distintas fuentes es parte de la naturaleza de la estructura de hipervínculos de la red, y la manera en que estamos acostumbrados a navegar la información hoy. Yendo más hacia atrás, el principio que está en la base de la estructura de hipervínculos de la red es el principio de la cita usado en los trabajos académicos. Citar y compartir materiales y sus fuentes y los datos detrás de la historia es una de las maneras básicas en las que el periodismo de datos puede mejorar le periodismo, lo que el fundador de WikiLeaks Julian Assange, llama el “periodismo científico”.

Al permitir a cualquier persona recurrir a fuentes de datos y encontrar información que es relevante, así como verificar afirmaciones y cuestionar los supuestos comunes, el periodismo de datos representa efectivamente la democratización masiva de recursos, herramientas, técnicas y metodologías que antes eran usadas por especialistas, fueran estos periodistas de investigación, científicos sociales, estadísticos, analistas u otros expertos. Si bien actualmente citar vínculos con fuentes de datos es algo específico del periodismo de datos, avanzamos hacia un mundo en el que los datos estarán integrados sin fisuras en el tejido de los medios. Los periodistas de datos tienen un rol importante en cuanto a ayudar a bajar las barreras a la comprensión y el manejo de datos, e incrementar la alfabetización en datos de sus lectores a escala masiva.

En este momento la comunidad creciente de personas que se llaman periodistas de datos es en gran medida diferente de la comunidad CAR más madura. Esperemos que en el futuro veamos vínculos más fuertes entre estas dos comunidades, del mismo modo que vemos a ONG y organizaciones de medios sociales como ProPublica y el Bureau of Investigative Journalism trabajando junto con medios tradicionales en investigaciones. Mientras la comunidad de periodismo de datos puede tener formas más innovadoras de difundir datos y presentar historias, el enfoque profundamente analítico y crítico de la comunidad CAR es algo de lo que el periodismo de datos podría aprender.

— Liliana Bounegru, European Journalism Centre

En la redacción

¿Cómo se ubica el periodismo de datos en las redacciones del mundo? ¿Cómo convencieron importantes periodistas a sus colegas de que es buena idea publicar bases de datos o lanzar aplicaciones de noticias basadas en datos? ¿Los periodistas debieran aprender a escribir código o trabajar en tándem con programadores talentosos? En esta sección analizamos el rol de los datos y el periodismo de datos en la Australian Broadcasting Corporation, la BBC, el Chicago Tribune, The Guardian, el Texas Tribune, y el Zeit Online. Aprendemos cómo descubrir y contratar buenos programadores, cómo atraer a la gente con un tema a través de hackatones y otros eventos, cómo colaborar a nivel internacional y cómo configurar modelos de negocios para periodismo de datos.

Qué contiene este capítulo?

- La iniciativa de periodismo de datos de ABC

- Periodismo de datos en la BBC

- El equipo de aplicaciones de noticias del Chicago Tribune

- El detrás de escena del Datablog de The Guardian

- Periodismo de datos en el Zeit Online

- Cómo contratar un hacker

- Ayuda externa de expertos a través de hackatones

- Seguir el rastro del dinero: colaboración internacional

- Nuestras historias aparecen en forma de código

- Kaas & Mulvad: Contenido Semi-Terminado para Grupos con Intereses Específicos.

- Modelos de negocios para periodismo de datos

La iniciativa de periodismo de datos de ABC

La Australian Broadcasting Corporation es la difusora pública nacional de Australia. Sus fondos anuales son de alrededor de 1.000 millones de dólares australianos, lo que permite sostener 7 cadenas radiales, 60 estaciones locales de radio, 3 servicios de televisión digital, un nuevo servicio de televisión internacional y una plataforma online con esta oferta siempre en expansión de contenido digital y generada por los usuarios. La última cifra disponible indica que tiene más de 4500 empleados de tiempo completo, y casi el 70% produce contenido.

Somos una difusora nacional muy orgullosa de nuestra independencia, aunque con fondos del estado, por ley estamos claramente separados. Nuestra tradición es de periodismo de servicio público independiente. La ABC es considerada la organización de noticias más confiable del país.

Estos son tiempos que entusiasman; bajo el mando de un director ejecutivo (el ex ejecutivo del diario Mark Scott), se ha alentado a los productores de contenido de ABC a ser “ágiles”, como dice el mantra corporativo.

Por supuesto que es más fácil decirlo que hacerlo.

Pero la iniciativa con la que se buscaba alentar esto, ha derivado en una competencia entre el personal por fondos para desarrollar proyectos multi-plataforma. Así se concibió el primer proyecto de periodismo de datos de la ABC.

En algún momento de comienzos de 2010 me metí en una sesión de propuestas para enfrentar a 3 jefes de “ideas” con mi proyecto.

Lo había estado masticando por un tiempo, llenándome con el periodismo de datos que ofrecía el ya legendario Datablog de The Guardian, y eso solo para empezar.

Mi argumento fue que no había duda de que en 5 años la ABC tendría su propia unidad de periodismo de datos. Era inevitable opiné. Pero la cuestión era cómo llegaríamos a eso y quién iniciaría la tarea.

Aquellos lectores que no conocen la ABC deben pensar en una vasta burocracia construida a lo largo de 70 años. Su oferta primaria siempre fue radio y televisión. Con el advenimiento de un sitio en la red, en la última década esta oferta de contenido se extendió a textos, imágenes fijas y un grado de interactividad hasta entonces inimaginada. El sitio web estaba forzando a la ABC a repensar cómo distribuía la torta (sus fondos) y qué tipo de torta estaba cocinando (contenido).

Por supuesto que es una obra en curso.

Pero otra cosa estaba pasando con el periodismo de datos. Gobierno 2.0: (que como descubrimos se cumple habitualmente en la difusión de datos en Australia) comenzaba a ofrecer nuevas maneras de narrar historias que hasta entonces estaban escondidas en ceros y unos. Comenté todo esto a las personas que me escuchaban. También dije que necesitábamos identificar nuevos conjuntos de capacidades y formar a periodistas en el manejo de nuevas herramientas. Necesitábamos un proyecto para comenzar a andar.

Y me dieron el dinero.

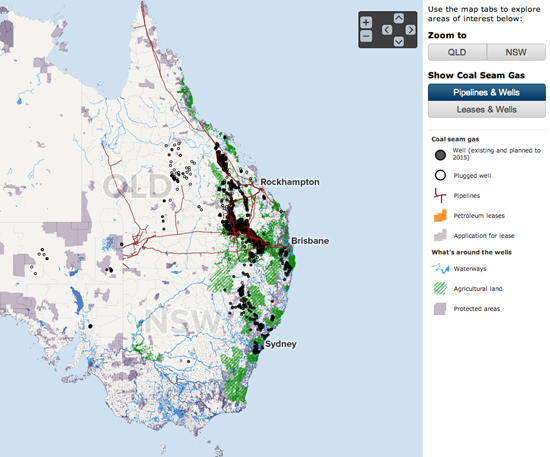

El 24 de noviembre de 2011, el proyecto multiplataforma de la ABC y ABC News Online salió en vivo con "Coal Seam Gas by the Numbers" (Las cifras de gas metano de carbón).

Se componía de 5 páginas de mapas interactivos, visualizaciones de datos y texto.

No era exclusivamente periodismo de datos, sino un híbrido de periodismo que nació de la mezcla de gente del equipo y la historia, que ahora es uno de los temas más calientes en Australia.

La joya era un mapa interactivo que muestra yacimientos y concesiones de gas metano de carbón en Australia. Los usuarios podían buscar por lugar y escoger entre distintos modos para ver concesiones o yacimientos. Usando el zoom los usuarios podían ver quién estaba a cargo de la exploración, la situación del yacimiento y la fecha de perforación. Otro mapa mostraba la ubicación de la actividad en gas metano de carbono con relación a sistemas de aguas subterráneas en Australia.

Teníamos visualizaciones de datos que específicamente abordaban la cuestión de la producción de desechos de sal y de agua que serían generados de acuerdo al escenario que se diera.

Otra sección del proyecto investigó el derrame de productos químicos en una cuenca fluvial local.

Nuestro equipo

- Un desarrollador y diseñador de sitios en la red

- Un periodista a cargo

- Un investigador part-time con experiencia en extracción de datos, planillas de cálculos Excel y depuración de datos.

- Un periodista part-time

- Un productor ejecutivo de consultor

- Un consultor académico con conocimientos de búsqueda de datos, visualización de gráficos y capacidades avanzadas de investigación.

- Los servicios de un gerente de proyecto y la asistencia administrativa de la unidad multiplataforma de ABC.

- Algo importante, también teníamos un grupo de referencia de periodistas y otros a los que consultamos según las necesidades.

¿De dónde obtuvimos los datos?

Los datos para los mapas interactivos fueron obtenidos de shapefiles (un tipo común de archivo para datos geo-espaciales) descargados de sitios web del Estado.

Otros datos sobre sal y agua fueron tomados de una variedad de informes.

Los datos sobre deshechos químicos se tomaron de permisos ambientales emitidos por el Estado.

¿Qué descubrimos?

"Las cifras de gas metano de carbón" era ambicioso en contenido y en escala. Lo más importante para mí era determinar qué habíamos aprendido y qué debíamos hacer de modo diferente la próxima vez.

El proyecto de periodismo de datos incorporó a mucha gente que normalmente no se encuentra en ABC: en términos del vulgo, hackers. Muchos no hablábamos el mismo idioma ni entendíamos lo que el otro grupo hace. ¡El periodismo de datos revoluciona las cosas!

Las cosas prácticas:

- La ubicación del equipo en un mismo lugar. Nuestro programador y diseñador estaban fuera del lugar y venían para reuniones. ¡Esto definitivamente no era óptimo! Hay que poner a todos en el mismo cuarto que los periodistas.

- Nuestro consultor de producción ejecutiva también estaba en otro nivel del edificio. Necesitábamos estar mucho más cerca, simplemente por la cuestión de poder pasar a verlo en cualquier momento.

- Escoger una historia que solo se basara en datos.

El cuadro grande: algunas ideas

Las grandes organizaciones de medios tienen que crear capacidad para responder a los desafíos del periodismo de datos. Mi intuición es que hay muchos técnicos y hackers ocultos en los departamentos técnicos de los medios desesperados por salir a la luz. Por lo que necesitamos “reuniones de periodistas y hackers”, talleres donde los geeks secretos (como en agente secreto – se refiere a gente que domina la técnica informática pero no tiene como trabajo las cuestiones técnicas sino que son periodistas, etc.), los periodistas más jóvenes, los programadores, y los diseñadores salen a jugar con periodistas más experimentados para compartir conocimientos y tener orientación. Tarea: ¡descargar este conjunto de datos y atacar!

Ipso facto, el periodismo de datos es interdisciplinario. Los equipos de periodismo de datos se componen de gente que en el pasado no habría trabajado junta. El espacio digital ha desdibujado las fronteras.

Vivimos en una comunidad política fracturada, desconfiada. El modelo de negocios que antes generaba periodismo independiente profesional –por imperfecto que sea- está al borde del colapso. Debemos preguntarnos, como muchos ya lo hacemos, cómo sería el mundo sin un cuarto poder viable. El periodista e intelectual estadounidense Walter Lippman comentó en la década de ‘20 que “se reconoce que no puede existir una opinión pública sana sin acceso a las noticias”. Esa afirmación es igualmente válida ahora. En el siglo XXI todo el mundo está en la blogósfera. Es difícil diferenciar a los periodistas profesionales del cuentero, el mentiroso, el simulador y quién defiende intereses creados. Cualquier sitio o fuente puede hacerse pasar por creíble, bien presentado y honesto. Las referencias confiables se mueren junto al camino. Y en este nuevo espacio de periodismo basura, los hipervínculos pueden llevar a los lectores interminablemente a otras fuentes más inútiles pero de aspecto brillante que no hacen más que llevar de un hipervínculo a otro en el salón digital de los espejos. El término técnico para esto es que el “macaneo” atonta el cerebro.

En el espacio digital todo el mundo es un narrador, ¿verdad? No. Si el periodismo profesional –y con ello me refiero a aquellos que se dedican a la narración de historias de modo ético, equilibrado, valiente en la búsqueda de la verdad- ha de sobrevivir, entonces el oficio debe reafirmarse en el espacio digital. El periodismo de datos es otra herramienta con la que navegaremos el espacio digital. Es donde mapearemos, daremos vuelta, separaremos, filtraremos, extraeremos y veremos la historia en medio de tantos ceros y unos. En el futuro trabajaremos junto a los hackers, los programadores, los diseñadores. Es una transición que requiere una seria acumulación de capacidades. Necesitamos gerentes de noticias que entiendan la conexión entre lo digital y el periodismo para empezar a invertir en esa construcción.

— Wendy Carlisle, Australian Broadcasting Corporation

Periodismo de datos en la BBC

El término “periodismo de datos” puede cubrir una gama de disciplinas y se usa de modos variados en las organizaciones de noticias, por lo que puede ser útil definir lo que queremos decir por “periodismo de datos en la BBC. En general el término cubre proyectos que usan datos para hacer una o más de las siguientes cosas:

- Permitir al lector descubrir información que es relevante para sí mismo.

- Revelar una historia que es llamativa y antes se desconocía

- Ayudar al lector a entender mejor una cuestión compleja.

Estas categorías pueden superponerse, y en un medio online a menudo pueden beneficiarse de algún nivel de visualización.

Que sea personal

En el sitio de BBC News hemos estado usando datos para ofrecer servicios y herramientas para nuestros usuarios desde hace más de una década.

El ejemplo más consistente, que se publicó por primera vez en 1999, es el de nuestras tablas de liga escolar, que usan los datos publicados anualmente por el Estado. Los lectores pueden encontrar las escuelas locales ingresando el código postal, y compararlas con una cantidad de indicadores. Periodistas de educación también trabajan con el equipo de programadores rastreando las historias antes de su publicación.

Cuando empezamos a hacer esto, no existía un sitio oficial que ofreciera al público la posibilidad de explorar datos. Pero ahora que el Departamento de Educación tiene su propio servicio nuestra tarea se concentra más en las historias que surgen de los datos.

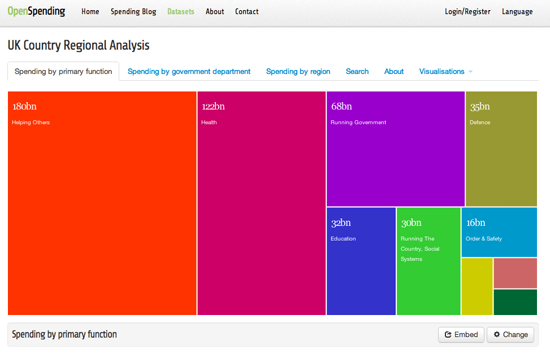

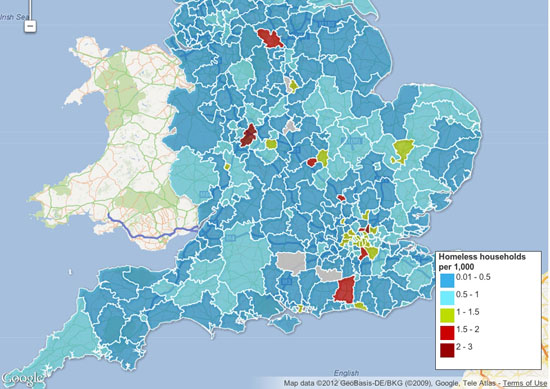

El desafío en este área debe ser dar acceso a datos en los que hay un claro interés público. Un ejemplo reciente de un proyecto en el que expusimos un gran conjunto de datos no disponible normalmente para el público en general, fue el informe especial "Todas las muertes en todos los caminos". Ofrecimos una búsqueda por código postal, permitiendo a los usuarios encontrar la locación de todos los accidentes fatales en caminos en el Reino Unido en la última década.

Visualizamos algunos de los datos y cifras principales que surgen de los datos policiales y, para dar al proyecto más dinámica y un rostro humano, hicimos equipo con la London Ambulance Association y BBC London radio y TV para rastrear choques en la capital cuando sucedían. Esto se reportó en vivo online, así como vía Twitter usando el hashtag #crash24, y las colisiones fueron incorporadas al mapa a medida que se informaban.

Herramientas simples

Además de proveer maneras de explorar grandes conjuntos de datos, también hemos tenido éxito en crear herramientas simples, que proveen relevantes recortes de información para los usuarios. Estas herramientas apelan a los que tienen poco tiempo y pueden no querer explorar análisis extensos. La capacidad de compartir fácilmente un dato personal es algo que hemos comenzado a incorporar como estándar.

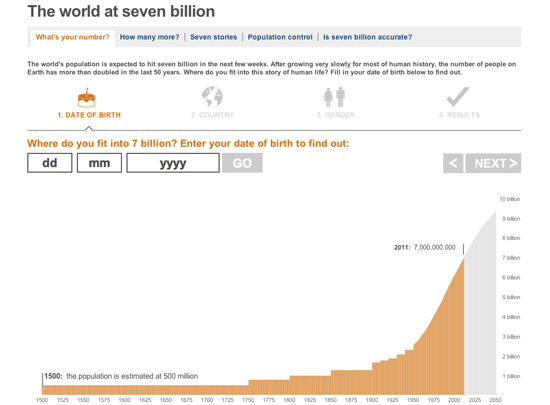

Un ejemplo simple de este enfoque es nuestro servicio “El mundo en 7000 millones: cuál es su número” publicado coincidentemente con la fecha oficial en la que la población mundial superó los 7000 millones. Ingresando su fecha de nacimiento, el usuario podía saber que “número” fue en términos de la población global cuando nació y luego compartir ese número vía Twitter o Facebook. La aplicación usa datos aportados por el fondo de desarrollo de la población de la ONU. Fue muy popular y se convirtió en el vínculo más usado en Facebook en el Reino Unido en 2011.

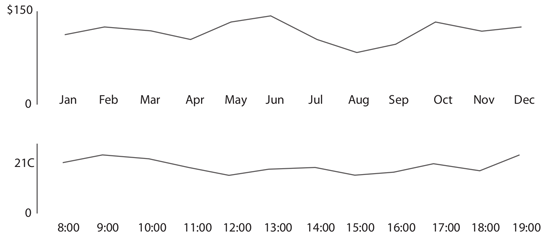

Otro ejemplo reciente es el calculador de presupuesto de la BBC, que permitió a los usuarios descubrir en qué medida estarán mejor o peor cuando entre en vigor el presupuesto del Tesoro, y luego compartir la cifra. Hicimos equipo con la firma contable KPMG LLP, que nos dio los cálculos basados en el presupuesto anual y entonces trabajamos duro para crear una interface atractiva que alentara a los usuarios a completar la tarea.

Explotar los datos

¿Pero dónde está el periodismo en todo esto? Encontrar historias en los datos es una definición más tradicional de periodismo de datos. ¿Hay una exclusiva enterrada en la base de datos? ¿Son precisas las cifras? ¿Prueban o no que existe el problema? Estas son todas preguntas que un periodista de datos o un periodista asistido por computadora debe hacerse. Pero puede llevar mucho tiempo estudiar un conjunto de datos muy grande con la esperanza de encontrar algo llamativo.

En esta área nos ha resultado más productivo asociarnos con programas o equipos de investigación que cuentan con el conocimiento experto y tiempo para investigar una historia. El programa Panorama de actualidad de la BBC pasó meses trabajando con el Centre for Investigative Journalism, recogiendo datos sobre la paga en el sector público. El resultado fue un documental de TV y un informe especial online, “La paga del sector público: las cifras”, donde se publicó todos los datos y se visualizaba con análisis sector por sector.

Además de asociarnos con periodistas de investigación, tener acceso a numerosos profesionales con conocimiento especializado es esencial. Cuando un colega del equipo del sector de economía analizó los datos de recortes del gasto publicados por el gobierno, llegó a la conclusión de que los hacía aparecer mayores de lo que eran en realidad. El resultado fue una historia exclusiva, “Encontrar sentido a los datos”, complementada por una clara visualización, que ganó un premio de la Royal Statistical Society.

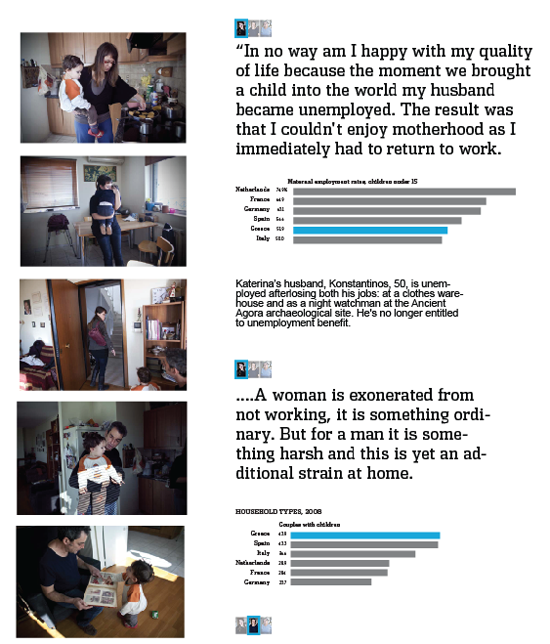

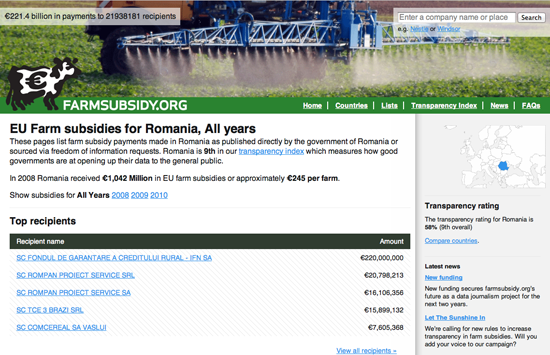

Comprender una cuestión